Transformers

Seq2Seq에서 RNN을 아예 빼버리고 attention으로 구성해보면 어떨까? → Transformer의 구조 현재는 seq2seq + attention에서는 하나의 벡터로…

2025/04/27

Jinsoolve.

앙상블 모델은 거의 항상 단일 모델보다 정확도가 높다.

모델 여러 개의 예측값을 가중치를 곱해서 앙상블 결과를 얻는다. 각각의 모델의 하이퍼파라미터를 GridSearch로 찾아 전체 앙상블 모델의 예측결과가 어떠한지 찾을 수 있다.

각각의 모델을 합칠 때 파이프라인을 잘 이용하자. 정규화나 표준화가 필요한 모델 같은 경우 파이프라인으로 전처리 과정을 합쳐준다.

Bagging은 Bootstrap Aggregating 의 줄임말로, bootstrap(랜덤하게 복원추출)하여 각 분류기에 전달하여 결과를 앙상블하는 것을 말한다.

대표적으로는 결정트리를 bagging하게 샘플링하는 랜덤포레스트가 있다.

랜덤 포레스트는 분산을 최적화시키기에는 좋지만, 편향을 잡는 데에는 약하다. 모델이 너무 단순하기 때문이다. 이것이 배깅을 수행할때 편향이 낮은 모델, 예를 들어 가지치기하지 않은 결정트리를 분류기로 사용하여 앙상블을 만드는 이유다.

adaboost(Adaptive Boosting)은 부스팅 앙상블 모델이다.

부스팅이란 앙상블 모델에서 하나의 모델을 훈련할 때 이전 모델의 결과를 참고해서 결과를 좋게 나오도록 하는 기법이다.

여기서 사용하는 분류기들은 단순한 모델(약한 분류기, 예를 들면 깊지 않은 결정트리)를 사용한다.

Adaboost는 이전 분류기에서 제대로 분류하지 못한 샘플들에 대해 가중치를 높이고 잘 분류한 샘플들에는 가중치를 낮춰서 결국에는 모두 제대로 분류할 수 있도록 만든다.

AdaBoost는 잘못 분류된 점을 이용하여 약분류기 학습의 가중치를 결정하였다면, GBM은 Gradient Descent 기법을 이용하여 손실함수를 최소화하는 방향으로 학습을 합니다.

GBM의 매개변수에 대해서 간단하게 설명하겠다.

GBM에는 다양한 모델들이 있다.

Seq2Seq에서 RNN을 아예 빼버리고 attention으로 구성해보면 어떨까? → Transformer의 구조 현재는 seq2seq + attention에서는 하나의 벡터로…

2025/04/27

성# Language Model(LM)이란? 언어 모델이라는 건, 사실 다음에 올 단어를 확��률로 예측하는 것이다. 이러한 언어 모델들을 어떻게 발전시켜왔는 지 살펴보자. 이미 이…

2025/04/27

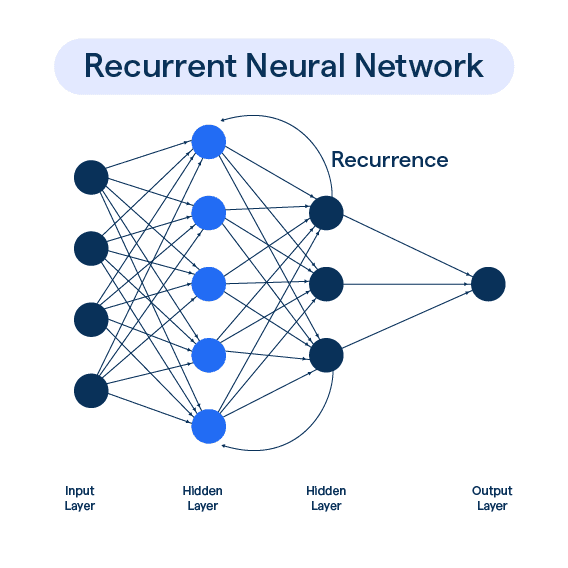

이전 포스트에서 RNN에서 Vanishing Gradient로 인해 장기 의존성 문제가 있다는 사실을 이야기했다. 이런 Vanishing Gradient를 해결하기 위해 크게…

2025/04/27

기존 RNN의 병목 현상을 해결하기 위해 Attention이 등장했다. Decoder에서 한 단어를 예상할 때, 해당 단어와 특별히 관련되어 있는 Encoder의 특정 단어를…

2025/04/27